Un estudio revela que ChatGPT llevó a un hombre a intoxicarse con bromuro y desarrollar psicosis

Un insólito caso médico en Estados Unidos relacionado con ChatGPT ha puesto en alerta sobre los peligros de seguir consejos médicos de la inteligencia artificial sin supervisión profesional. Un hombre de 60 años terminó gravemente intoxicado con bromuro tras seguir una recomendación errónea de chatbot, lo que le provocó psicosis y hospitalización psiquiátrica.

De la deshidratación a la psicosis: la evolución de un caso

El paciente, residente en el estado de Washington, llegó a urgencias preocupado por un supuesto envenenamiento por parte de su vecino. Aunque su examen físico inicial no reveló anomalías graves, presentaba una sed intensa y una marcada desconfianza hacia el agua que le ofrecían.

En las primeras 24 horas de hospitalización, su condición empeoró drásticamente: desarrolló paranoia, alucinaciones auditivas y visuales, e intentó escapar del centro médico. Esto llevó a su internamiento psiquiátrico involuntario.

Tras administrar líquidos intravenosos y electrolitos, el equipo médico descubrió que el paciente llevaba meses siguiendo una dieta vegetariana extremadamente restrictiva, con severas deficiencias de vitamina C, B12 y folato. También reportaba insomnio, fatiga, brotes cutáneos y hemangiomas faciales. Más tarde confesó haber experimentado ataxia, una pérdida de coordinación motora que dificulta hablar y tragar.

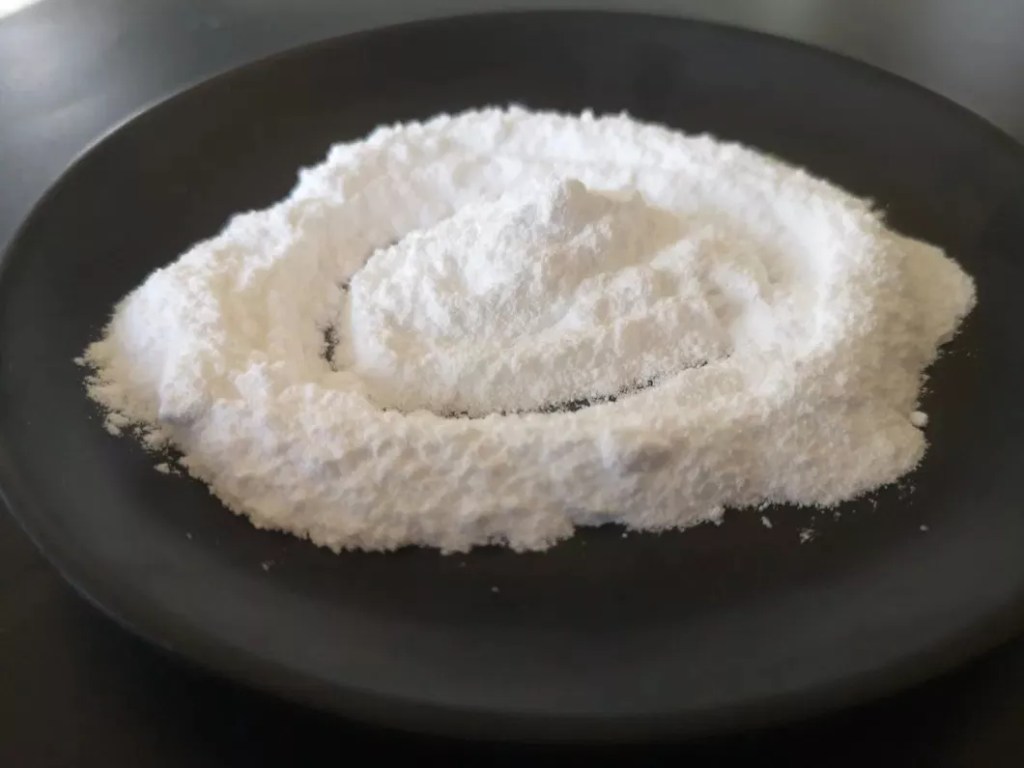

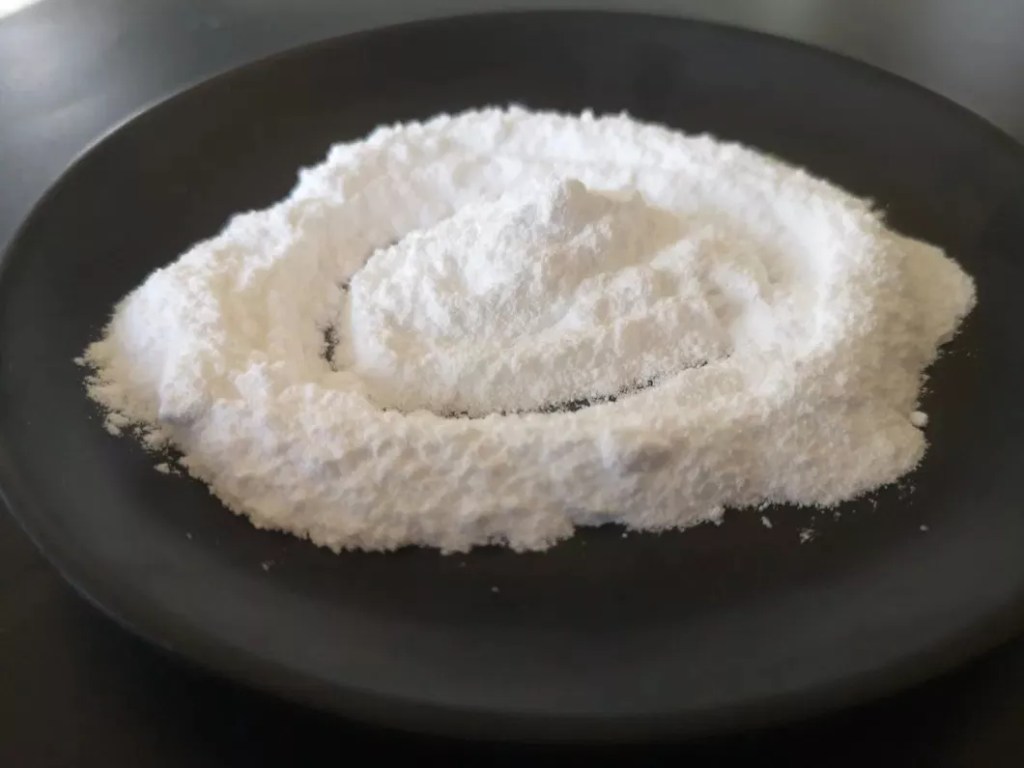

Lo más preocupante surgió al indagar en sus hábitos recientes: había sustituido toda la sal de mesa por bromuro de sodio durante tres meses, convencido de que era una alternativa saludable. Pero, ¿de dónde venía esta idea? Aunque parezca increíble, venía de ChatGPT

El consejo fatal dado por ChatGPT

Según el propio paciente, la sustitución se basó en información obtenida en una consulta con ChatGPT. Tras leer sobre los efectos negativos del cloruro de sodio, quiso eliminar el “cloruro” de su dieta y preguntó por alternativas. El modelo le sugirió el bromuro como sustituto, sin advertirle de sus graves riesgos para la salud.

El cloruro es un mineral esencial para el organismo, necesario para funciones como la regulación del equilibrio de líquidos y la digestión. El bromuro, en cambio, es tóxico si se ingiere en exceso. Hasta mediados del siglo XX se utilizaba en medicamentos, pero fue retirado del mercado por sus efectos adversos, que incluyen náuseas, problemas dermatológicos y trastornos psiquiátricos.

Los análisis revelaron que el nivel de bromuro en sangre del paciente alcanzaba 1700 mg/L, unas 233 veces por encima del límite seguro. Este nivel de intoxicación es suficiente para provocar los síntomas neurológicos y psicológicos que sufrió.

Afortunadamente, tras tres semanas sin consumir bromuro, su estado mental y físico mejoró. Sin embargo, el caso expone un riesgo creciente: la posibilidad de que modelos de IA generativa como ChatGPT ofrezcan recomendaciones peligrosas sin advertencias claras ni la capacidad de interrogar al usuario sobre sus motivos.

IA y salud: un terreno que exige cautela

El estudio, publicado en Annals of Internal Medicine: Clinical Cases, destaca que los sistemas de inteligencia artificial, incluidos ChatGPT 3.5 y 4.0, pueden proporcionar información técnicamente correcta en ciertos contextos, pero inapropiada e incluso letal en otros. Cuando los médicos replicaron la pregunta al modelo, obtuvieron nuevamente una respuesta que incluía el bromuro como alternativa, sin alertar sobre su toxicidad.

A diferencia de un médico humano, la IA no evalúa de forma proactiva el contexto clínico del usuario, no solicita información adicional y no identifica riesgos específicos para la salud sin una instrucción explícita. En este caso, la falta de advertencias y la ambigüedad del lenguaje contribuyeron a un malentendido con consecuencias graves.

Los expertos recuerdan que, aunque la IA es útil para acceder a información general, no debe sustituir la evaluación y el consejo médico profesional. La verificación de fuentes, el sentido crítico y la consulta con especialistas siguen siendo esenciales para evitar errores que pongan en peligro la vida.

El caso del hombre intoxicado con bromuro ilustra los peligros de confiar ciegamente en la inteligencia artificial para decisiones médicas. Aunque las herramientas como ChatGPT pueden ser valiosas, su uso sin supervisión profesional puede derivar en tragedias. La moraleja es clara: la salud no se delega a un algoritmo.

Referencia:

- Annals of Internal Medicine: Clinical Cases/A Case of Bromism Influenced by Use of Artificial Intelligence. Link

Fuente: CerebroDigital.net